Parquetファイルからインポート

Apache Parquetは、効率的なデータストレージと検索のために設計されたオープンソースの列指向データファイル形式です。複雑なデータを大量に管理するための高性能な圧縮およびエンコーディングスキームを提供し、さまざまなプログラミング言語や分析ツールでサポートされています。

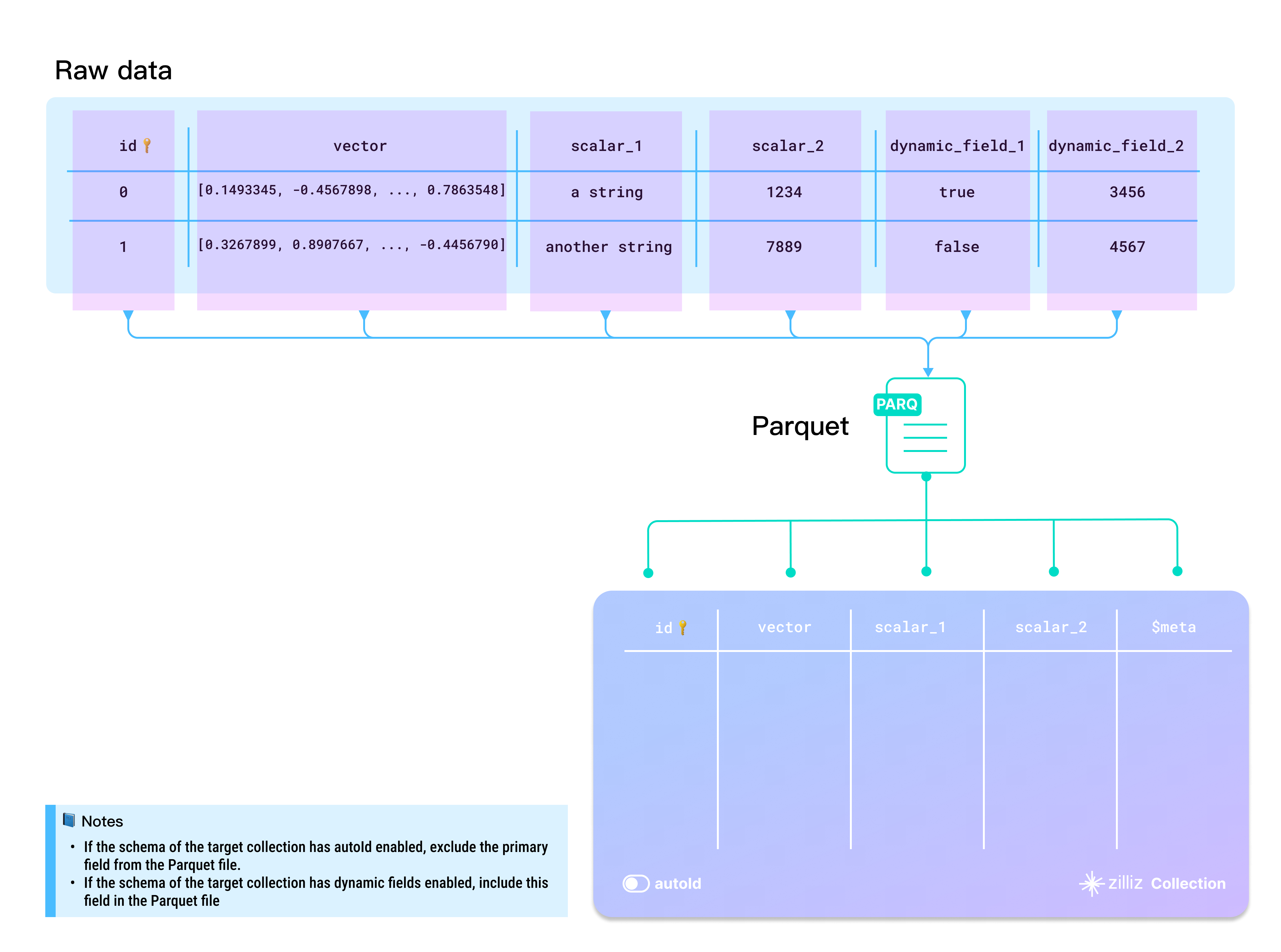

生データをParquetファイルに準備するには、BulkWriterツールを使用することをお勧めします。次の図は、生データをParquetファイルにマッピングする方法を示しています。

- AutoIDを有効にするかどうか

「id」フィールドは、コレクションのプライマリフィールドとして機能します。プライマリフィールドを自動的にインクリメントするには、スキーマで「AutoID」を有効にします。この場合、ソースデータの各行から「id」フィールドを除外する必要があります。

- 動的フィールドを有効にするかどうか

ターゲットコレクションで動的フィールドが有効になっている場合、定義済みスキーマに含まれていないフィールドを格納する必要がある場合は、書き込み操作中に$meta列を指定し、対応するキー値データを指定できます。

- 大文字と小文字を区別する

ディクショナリのキーとコレクションのフィールド名は大文字と小文字を区別します。データ内のディクショナリのキーがターゲットコレクションのフィールド名と完全に一致するようにしてください。ターゲットコレクションにidという名前のフィールドがある場合、各エンティティディクショナリにはidという名前のキーが必要です。IDまたはIdを使用するとエラーが発生します。

ディレクトリ構造

Parquetファイルにデータを準備する場合は、以下のツリー図に示すように、すべてのParquetファイルをソースデータフォルダに直接置くことができます。

├── parquet-folder

│ ├── 1.parquet

│ └── 2.parquet

データのインポート

データの準備ができたら、次のいずれかの方法を使用して、Zilliz Cloudコレクションにデータをインポートできます。

ファイルが比較的小さい場合は、フォルダまたは複数パスの方法を使用して一度にすべてをインポートすることをお勧めします。このアプローチにより、インポート過程で内部最適化が可能になり、後でリソースの消費を減らすことができます。

Milvus SDKを使用して、Zilliz Cloudコンソールからデータをインポートすることもできます。詳細については、「データのインポート(コンソール)」および「データのインポート(RESTful API)」を参照してください。

複数のパスからファイルをインポートする(推奨)

複数のパスからファイルをインポートする場合は、各Parquetファイルパスを個別のリストに含め、次のコード例のようにすべてのリストを上位レベルのリストにグループ化します。

curl --request POST \

--url "https://api.cloud.zilliz.com/v2/vectordb/jobs/import/create" \

--header "Authorization: Bearer ${TOKEN}" \

--header "Accept: application/json" \

--header "Content-Type: application/json" \

-d '{

"clusterId": "inxx-xxxxxxxxxxxxxxx",

"collectionName": "medium_articles",

"partitionName": "",

"objectUrls": [

["s3://bucket-name/parquet-folder-1/1.parquet"],

["s3://bucket-name/parquet-folder-2/1.parquet"],

["s3://bucket-name/parquet-folder-3/"]

],

"accessKey": "",

"secretKey": ""

}'

フォルダからファイルをインポートする

ソースフォルダにインポートするParquetファイルのみが含まれている場合は、次のようにソースフォルダをリクエストに含めることができます。

curl --request POST \

--url "https://api.cloud.zilliz.com/v2/vectordb/jobs/import/create" \

--header "Authorization: Bearer ${TOKEN}" \

--header "Accept: application/json" \

--header "Content-Type: application/json" \

-d '{

"clusterId": "inxx-xxxxxxxxxxxxxxx",

"collectionName": "medium_articles",

"partitionName": "",

"objectUrls": [

["s3://bucket-name/parquet-folder/"]

],

"accessKey": "",

"secretKey": ""

}'

単一のファイルをインポート

準備したデータファイルが1つのParquetファイルである場合は、次のコード例に示すようにインポートします。

curl --request POST \

--url "https://api.cloud.zilliz.com/v2/vectordb/jobs/import/create" \

--header "Authorization: Bearer ${TOKEN}" \

--header "Accept: application/json" \

--header "Content-Type: application/json" \

-d '{

"clusterId": "inxx-xxxxxxxxxxxxxxx",

"collectionName": "medium_articles",

"partitionName": "",

"objectUrls": [

["s3://bucket-name/parquet-folder/1.parquet"]

],

"accessKey": "",

"secretKey": ""

}'

ストレージパス

Zilliz Cloudは、クラウドストレージからのデータインポートをサポートしています。以下の表は、データファイルの可能なストレージパスを示しています。

クラウド | クイックな例 |

|---|---|

AWS S3 |

|

Google Cloud Storage |

|

Azure Bolb |

|

限界

クラウドストレージからParquet形式のデータをインポートする際には、いくつかの制限を守る必要があります。

アイテム | 説明する |

|---|---|

一度に複数のファイルをインポートする | はい |

インポートごとの最大ファイル体格 | クラスタの空き容量:合計512 MB サーバーレス&専用クラスター

|

使用可能なデータファイルの場所 | リモートファイルのみ |

生データをパルケファイルに準備するはBulkWriterツールを使用することをお勧めします。上の図のスキーマに基づいて準備されたサンプルデータをダウンロードするにはここをクリックしてください。